Конец цифровой эпохи. Обучение Stable Diffusion на работах Драгана Бибина

концепция

Наблюдая за развитием искусственного интеллекта, я часто размышляю над будущем технологий. Я вижу два варианта развития будущего в его крайней точке. Первый — полное подчинение человечества технологиям и сверхразвитому ИИ. Второй — потеря контроля и постепенное разрушение цифрового мира.

В этой работе мне хотелось отразить свои впечатления от второго варианта развития событий. Моим стилистическим ориентиром стало творчество сербского художника Драгана Бибина.

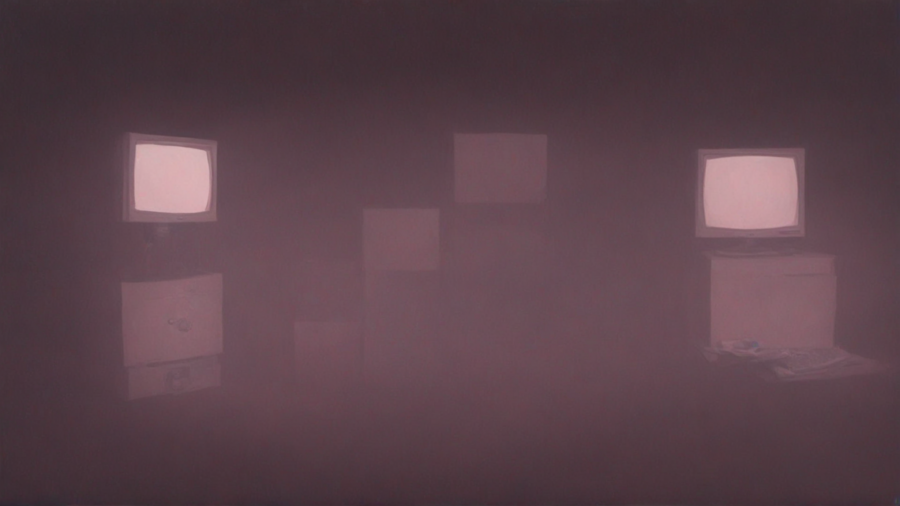

итоговая серия изображений

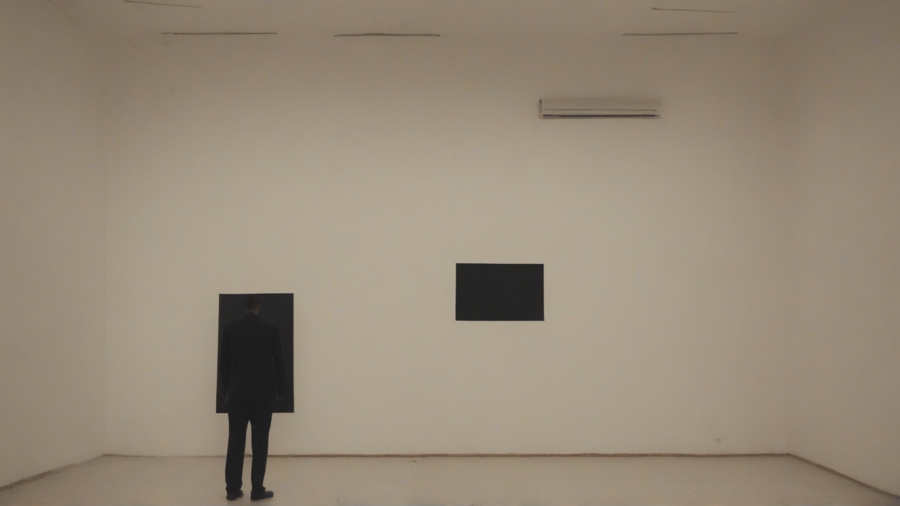

Пустые экраны — окна в мир, который больше не существует. Память о цифровом мире стерта.

Человек теперь смотрит не в экран, а внутрь себя. Там так же темно, как в экране монитора.

Итоговая серия изображений передает ощущение отстраненности в мире, где люди разучились жить без технологий, коммуникация нарушена, а цветные мониторы навсегда погасли, превратившись в «черное зеркало»

Разбитый экран стал сетью забвения. Провода — его нити.

Человек бродит по комнатам, поглощённым пустотой. Где остались те связи, которые когда-то наполняли мир смыслом?

процесс обучения

Для дообучения Stable Diffusion использовались DreamBooth и LoRA, а также подготовленный датасет из 40 квадратных изображений картин Драгана Бибина из его серий Unfinished и Deimos.

Выбранные произведения погружают зрителя в мрачную атмосферу и передают ощущение тревоги. Эстетика этих картин близка моей концепции. Я хотела передать в своей серии чувство потерянности и страха, пугающую отчужденность «мертвого» цифрового мира.

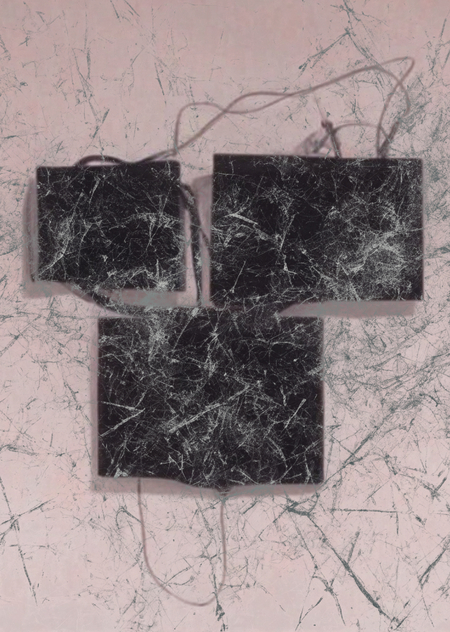

Несколько примеров из датасета

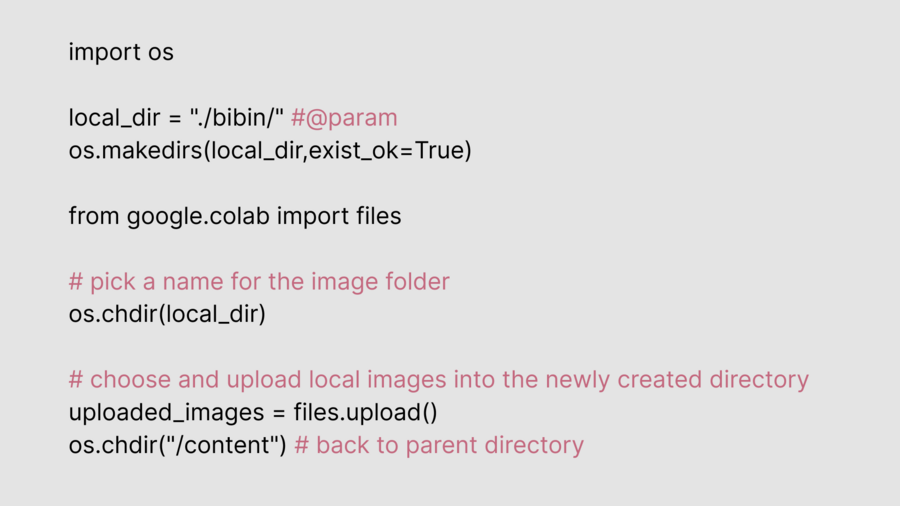

Чтобы увеличить объем памяти, использовалась удаленная среда выполнения в Google Colab. Мне хватило этого ресурса, чтобы дважды обучить модель и сгенерировать около 30 картинок.

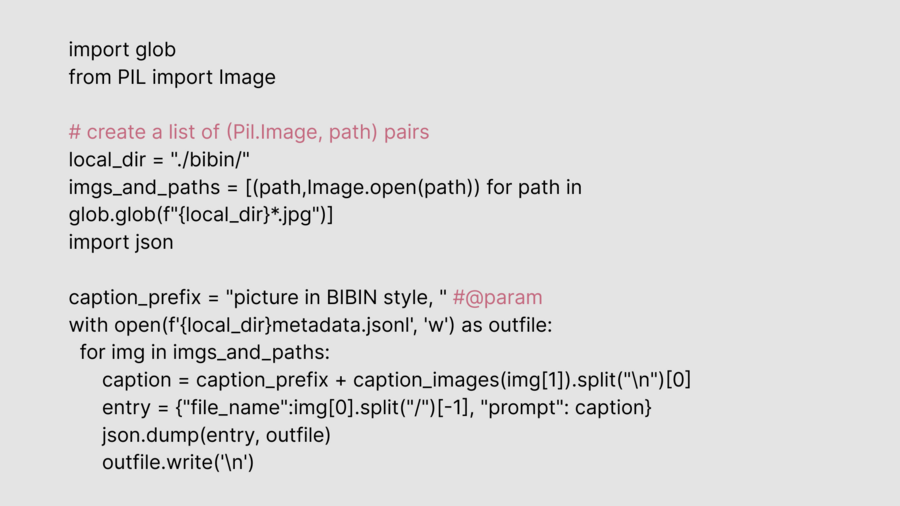

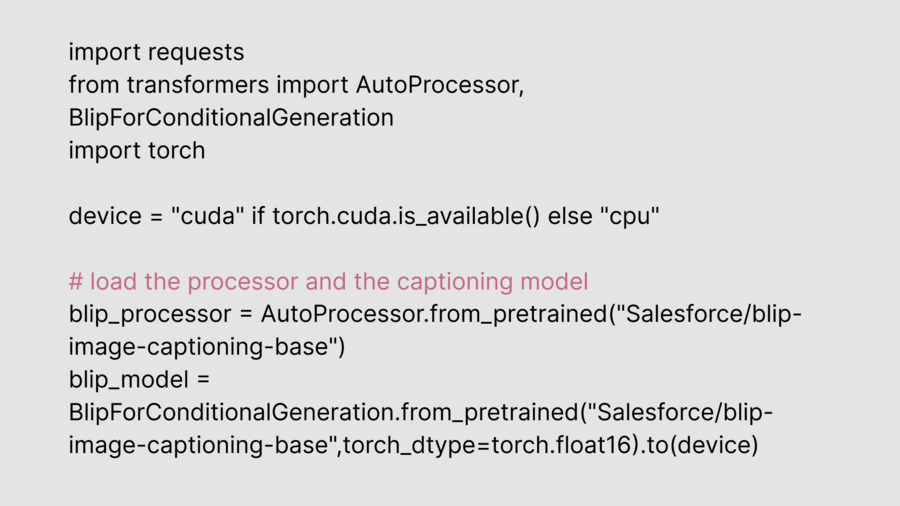

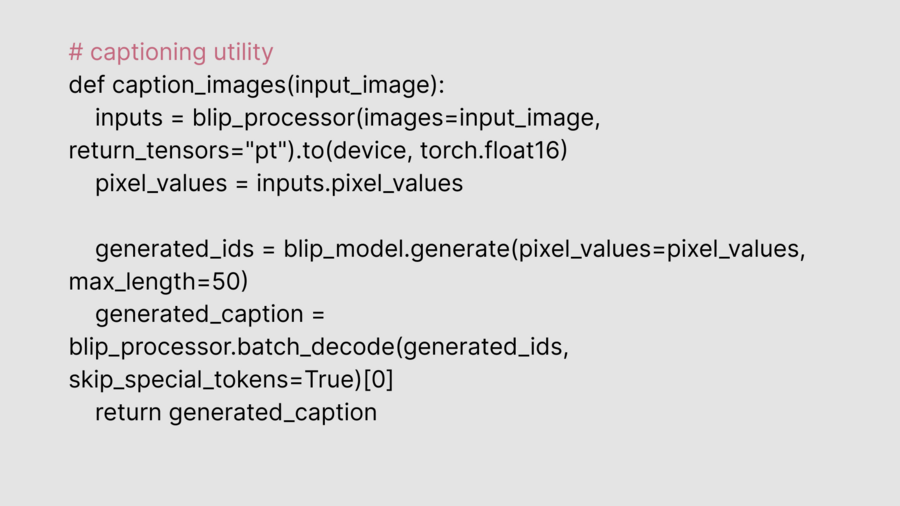

После загрузки датасета, использовалась модель BLIP для генерации подписей к изображениям. Эти данные отправились на обучение Stable Diffusion, которая опиралась на описания картинок.

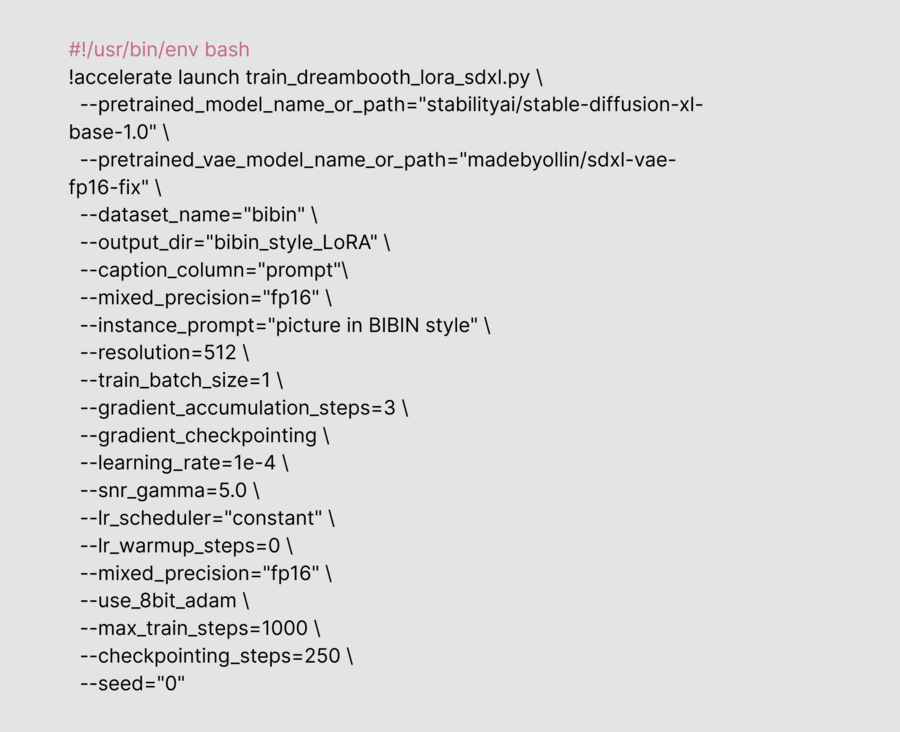

Загрузка датасета

Тренировка модели проходила дважды, потому что изначально я выбрала обучение на 500 шагов. Позже, после нескольких неудачных генераций, я решила, что модель еще плохо понимает стиль, и стала обучать ее на 1000 шагов. Полученную во второй раз модель я загрузила на Hugging Face.

На этапе генераций картинок я поняла, что нужно увеличивать не только количество шагов, но и количество изображений в датасете — так стиль художника будет более узнаваемым.

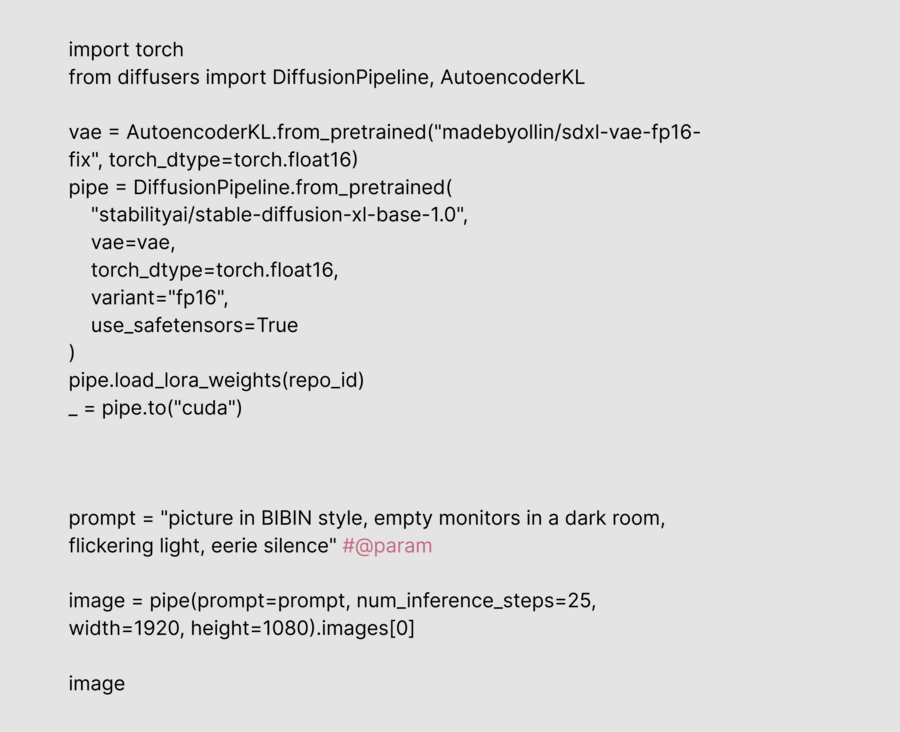

Параметры для обучения DreamBooth

Составить промпты в соответствии с моей концепцией помогала нейросеть ChatGPT. Несмотря на то, что описанные сюжеты понравились мне, они совсем не понравились Stable Diffusion: от многих идей пришлось отказаться, потому что нейросеть рисовала не то.

Проблема возникала, когда я брала длинный промпт, либо использовала слова, которая нейросеть понимает по-своему. Например, я хотела изобразить голограммы, а вместо этого получила силуэты девушек в импрессионистическом стиле.

Несколько примеров неудачных генераций

Выводы, к которым я пришла: 1. Чем короче промпт, тем точнее результат 2. Некоторые слова нейросеть не понимает, их нужно заменять 3. Обучать стоит на большем количестве изображений 4. Для генерации нужны большие ресурсы, а Google Colab и Kaggle предоставляют их с ограничениями ;)

описание применения генеративной модели

Генрация изображений: Stable Diffusion XL с DreamBooth и LoRA Описание для картинок датасета: BLIP Промпты для генерации: ChatGPT